Chỉ sau chưa đầy hai năm từ khi bắt tay xây dựng, mô hình ngôn ngữ lớn (LLM) do Zalo phát triển đã bước đầu chứng minh hiệu quả bằng việc được ứng dụng vào loạt sản phẩm thực tế, phục vụ hàng triệu người dùng tại Việt Nam. Đáng chú ý nhất là Kiki Info – trợ lý AI tổng hợp hoạt động dưới dạng Official Account (OA) trên nền tảng Zalo, cung cấp ba nhóm tính năng chính: hỏi đáp kiến thức, sáng tạo nội dung và gợi ý giải trí.

Theo thống kê từ đội ngũ phát triển, chỉ trong gần 2 tháng, Kiki Info đã thu hút hơn 1 triệu lượt người dùng. Đây là minh chứng cho nhu cầu sử dụng các công cụ AI thân thiện, hiệu quả và phù hợp với ngữ cảnh văn hóa – ngôn ngữ của người Việt.

Bên cạnh đó, sản phẩm thiệp AI cũng được xây dựng trên nền tảng mô hình LLM của Zalo đạt mốc hơn 15 triệu thiệp được tạo và gửi trong vòng 60 ngày. Không chỉ là công cụ truyền tải lời chúc, thiệp AI còn góp phần mang lại trải nghiệm kết nối cảm xúc mới lạ, mang màu sắc cá nhân hóa.

Từ khoảng cách công nghệ đến thành tựu vượt trội

Việc xây dựng một mô hình ngôn ngữ lớn hoàn toàn bằng nội lực trong nước từng được xem là nhiệm vụ khó khả thi. Ngay từ những ngày đầu, đội ngũ phát triển đã phải làm việc trong điều kiện thiếu thốn: hệ thống máy chủ hạn chế, tài nguyên dữ liệu tiếng Việt nghèo nàn, và kinh nghiệm triển khai LLM còn ít ỏi so với các quốc gia dẫn đầu.

Tuy nhiên, thay vì phụ thuộc vào nguồn lực bên ngoài, Zalo đã chủ động xây dựng lộ trình phát triển riêng. Đáng chú ý là việc đầu tư vào hệ thống máy chủ gồm 8 thiết bị DGX H100, sử dụng GPU hiệu suất cao từ Nvidia – dòng phần cứng vốn khan hiếm trên toàn cầu vào thời điểm đó. Nhờ đó, nhóm kỹ sư đã có thể triển khai huấn luyện mô hình LLM trên nền tảng có hiệu năng lên tới 256 petaFLOPS.

Đồng thời, quá trình huấn luyện cũng được tối ưu hóa thông qua việc xây dựng tập dữ liệu tiếng Việt chuyên biệt, đảm bảo độ phong phú và tính cập nhật. Trước khi sở hữu hạ tầng mạnh, nhóm kỹ sư từng bước rèn luyện qua GPU dân dụng, thử nghiệm mô hình nhỏ, từ đó tích lũy kinh nghiệm huấn luyện AI bài bản.

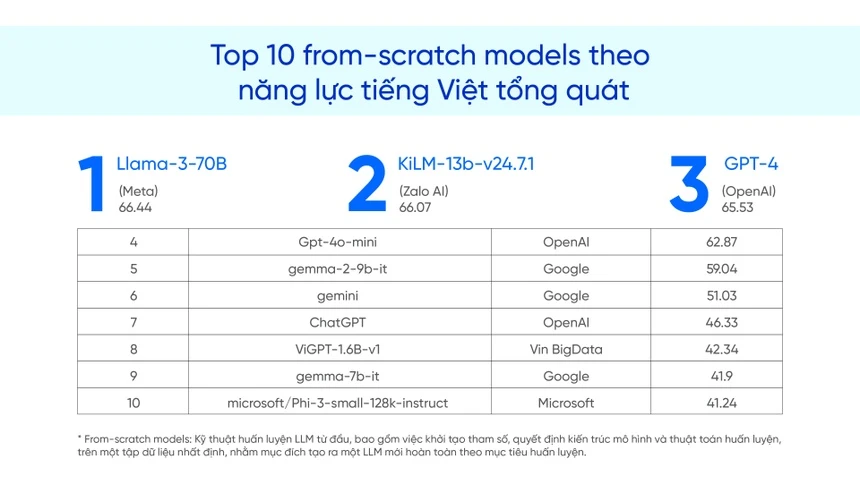

Ghi danh trên bảng xếp hạng ngôn ngữ lớn nhất Việt Nam

Thành quả của những nỗ lực trên là việc mô hình ngôn ngữ lớn của Zalo vươn lên vị trí Top 2 trong bảng xếp hạng VMLU (Vietnamese Multitask Language Understanding) cuối năm 2024. Đây là nền tảng đánh giá uy tín dành riêng cho các LLM sử dụng tiếng Việt, do Viện Nghiên cứu VinAI phối hợp với nhiều đơn vị nghiên cứu tổ chức.

Cụ thể, mô hình LLM của Zalo đã vượt qua hàng loạt tên tuổi lớn như GPT-4, Gemma-2-9B-IT của Google hay Phi-3 của Microsoft, chỉ đứng sau Llama-3-70B của Meta – một trong những LLM có quy mô lớn nhất thế giới.

Thành tích này đặc biệt có ý nghĩa khi xét tới hoàn cảnh khởi điểm: từ một hệ sinh thái nội địa, Zalo đã tự mình xây dựng toàn bộ quy trình huấn luyện mô hình từ kiến trúc thuật toán, chọn tham số đến phát triển dữ liệu đầu vào. Trong một lĩnh vực mà việc “làm chủ từ đầu” là bài toán nan giải ngay cả với các tập đoàn quốc tế, đây được xem là bước tiến đáng ghi nhận.

Khác với nhiều mô hình AI quốc tế vốn gặp rào cản về ngôn ngữ và ngữ cảnh khi triển khai tại Việt Nam, LLM của Zalo cho thấy sự tương thích cao nhờ được thiết kế riêng cho tiếng Việt. Điều này giúp cải thiện đáng kể độ chính xác khi tra cứu thông tin, đồng thời tạo điều kiện cho AI phát triển các ứng dụng sáng tạo phù hợp với hành vi người dùng trong nước.

Ngoài ra, khả năng sáng tạo nội dung tiếng Việt của mô hình được đánh giá cao. Ở phiên bản 2023, LLM của Zalo với 7 tỷ tham số đã đạt hiệu suất 150% so với GPT-3.5 trên bộ tiêu chuẩn VMLU con số cho thấy chất lượng mô hình không chỉ đến từ kích thước, mà còn nằm ở cách thức huấn luyện và khả năng tối ưu hóa dữ liệu.